Machine learning pour le traitement d'image

Découvrez les techniques du Machine Learning (Apprentissage Automatique) / Deep Learning (Apprentissage Profond) avec OpenCV et en C++.

Objectif de la formation

Durant cette formation, nous ferons un tour d'horizon des principales techniques basées sur les réseaux de neurones (technique dite du "deep learning" ou "apprentissage profond") pour des applications en traitement d'image (classification d'images, détection d'objets, etc.). Pour ce faire, la formation alternera présentations théoriques et travaux pratiques (C++, OpenCV) où les participants pourront mettre en pratique immédiatement les algorithmes abordés sur des exemple concrets. Une machine virtuelle sera fournie en début de formation avec l'environnement complet de développement.

Durée de la formation

Trois jours

Date et lieu de la formation

Lieu : Toulouse, date : sur demande.

Inscription

Formulaire d'inscription disponible ici.

Contenu

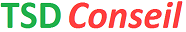

| I - Apprentissage Supervisé | |

| Durant cette première partie, nous allons traiter de l'apprentissage dit supervisé, qui nous servira de cadre général pour formuler les réseaux de neurones et leur apprentissage. | |

|  |

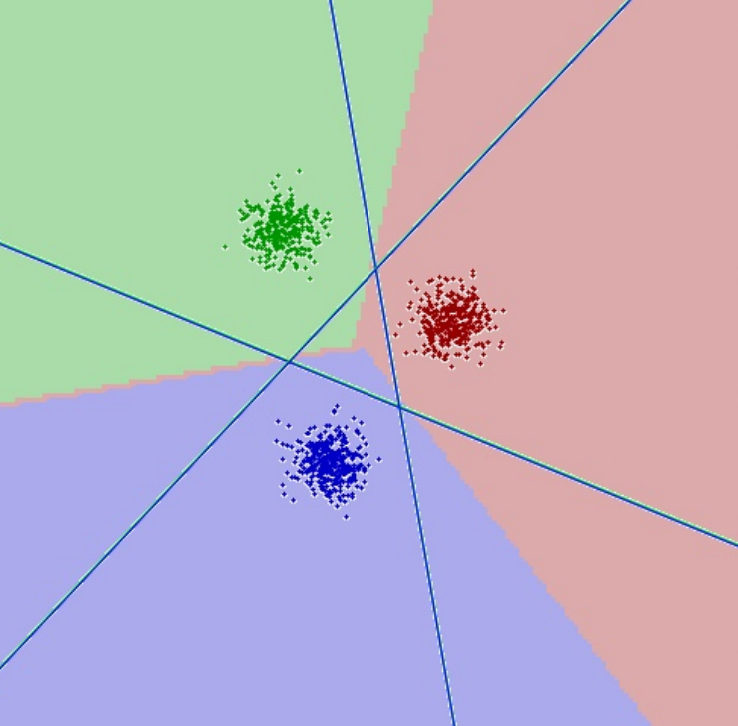

| II - Réseaux de Neurones Artificiels | |

| Dans cette partie, nous allons étudier les RNA généralistes (de manière non spécifique au traitement d'image). | |

|  |

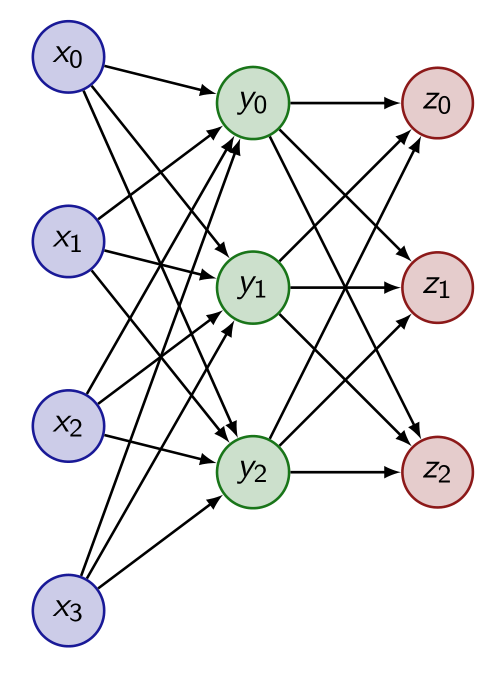

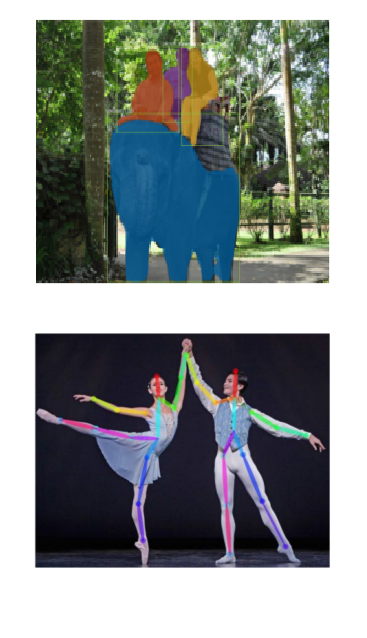

| III - Réseaux Convolutifs | |

| Dans cette partie, nous aborderons les réseaux de neurones dits convolutifs, des réseaux de neurones créés spécifiquement pour le traitement d'image. Nous étudierons en particulier les réseaux de classification, qui servent de base à beaucoup d'autres applications en traitement d'image (détection, segmentation, etc.). | |

|  |

| IV - Réseaux Spécialisés | |

|  |

Travaux pratiques

Tout au long de l'atelier l'ensemble des points abordés sera illustré par des exemples et de petits exercices en C++ / OpenCV qui vous permettront de mettre en oeuvre directement les notions abordées.